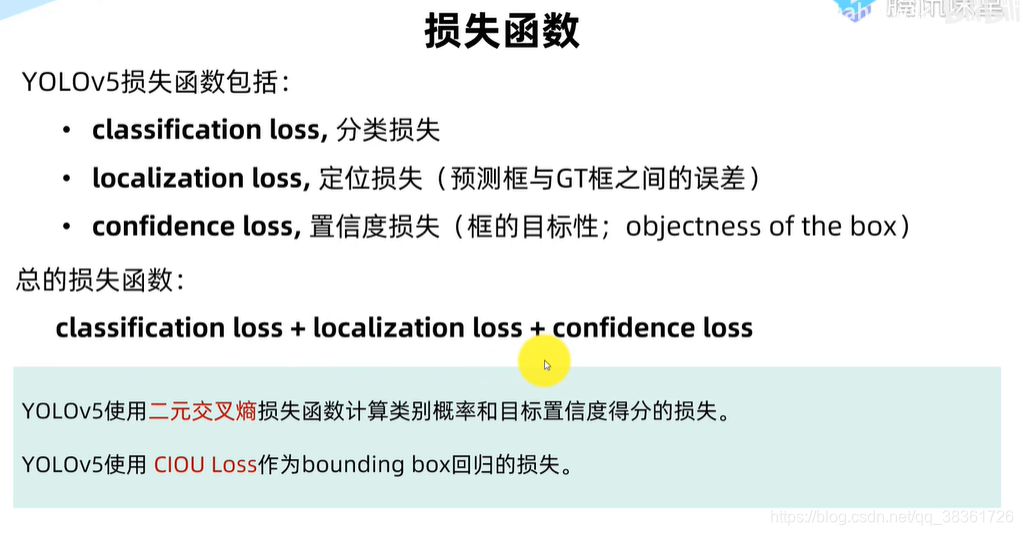

(五)yolov5修改检测头detect为ASFF(自适应特征融合)|涨点

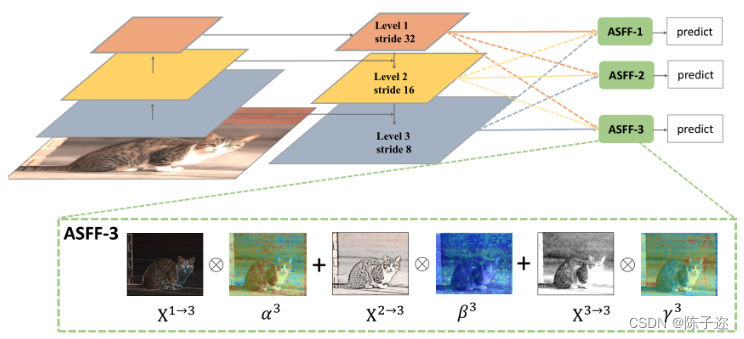

ASFF:Adaptively Spatial Feature Fusion (自适应空间特征融合)

论文来源:Learning Spatial Fusion for Single-Shot Object Detection

1.背景

不同特征尺度之间的不一致性是基于特征金字塔的单阶段检测器的主要缺陷。

本文提出了一种新的基于数据驱动的金字塔特征融合策略,称为自适应空间特征融合(ASFF)。它学习了空间过滤冲突信息的方法来抑制不一致性,从而提高了特征的尺度不变性,并且开销小。

所提出的方法使网络能直接学习如何在空间上过滤其他层次的特征,以便只保留有用的信息进行组合。在每个空间位置,不同层次的特征被自适应地融合,也就是说,一些特征在这个位置携带矛盾的信息时可能被过滤掉,而一些特征可能以更具争议性的线索支配。

提出一种自适应特征融合方法,ASFF

ASFF可以提高FPN形式网络的性能

借助ASFF策略和可靠的YOLOv3基线,在MS COCO数据集上实现了最佳的速度精度折衷

解决单发检测器特征金字塔的不一致性。

特征金字塔的一大缺点是不同尺度特征的不一致性,特别是对于一阶段检测器。确切地说,在FPN形式的网络中启发式地选择特征,高层语义信息中检测大目标、低层语义信息中检测小目标。当某个目标在某一层被当做正类时,相应地该目标区域在其它层被当做负类。如果一幅图像中既有大目标也有小目标,那么不同层间的特征的不一致性将会影响最后检测结果(大目标的检测在某一层,小目标的检测在另一层,但是网络的多尺寸检测不会仅仅检测一个特定的区域,而是综合整幅图进行检测。在特征融合时,其它层很多无用的信息也会融合进来)。

为了充分利用高层特征的语义信息和底层特征的细粒度特征,很多网络结构都会采用FPN的方式输出多层特征,但是无论是类似于YOLOv3还是RetinaNet他们多用concatenation或者element-wise这种直接衔接或者相加的方式,作者认为这样并不能充分利用不同尺度的特征。

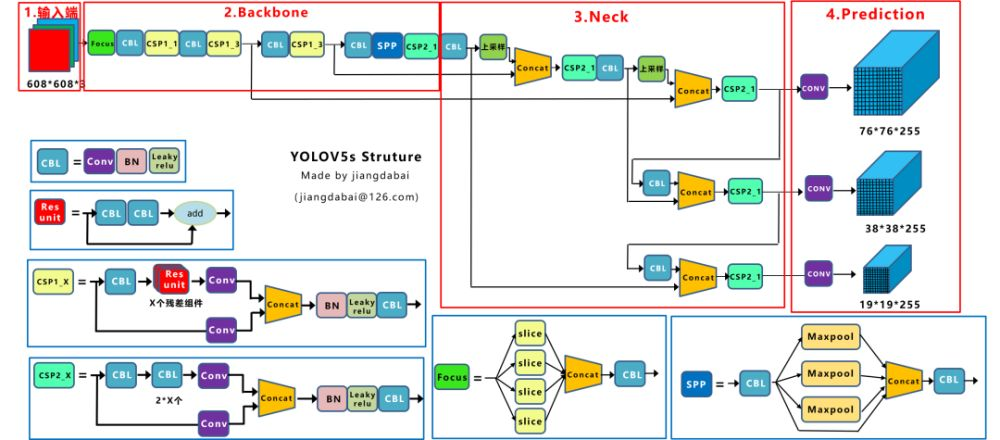

2.YOLOv5代码修改

这里的代码我结合yolov5的网络结构进行过修改,所以会与原代码不同

2.1第一步,在models/common.py文件最下面添加下面的代码

1 | |

2.2 第二步,在models/yolo.py文件的Detect类下面添加下面的类(我的是在92行加的)

1 | |

2.3 第三步,在有yolo.py这个文件中,出现 Detect, Segment这个代码片段的地方加入ASFF_Detect

在yolo.py文件中的class BaseModel(nn.Module):其中部分代码修改如下

1 | |

下面这部分代码不需要修改,因为一般会在yolov5s.yaml中的模型中最后一层修改为ASFF_Detect,但是有的版本这部分代码不一样,如果是类似于if isinstance(m, (Detect, Segment)):这样的代码,依然需要在后面添加ASFF_Detect

1 | |

class DetectionModel(BaseModel):类其中部分代码修改如下

1 | |

在yolo.py文件parse_model函数下做如下修改

1 | |

2.4 第四步,修改yolov5s_asff.yaml

在最后一层将Detect修改为ASFF_Detect

1 | |